ML习题和零散知识点

1

梯度下降法是求解机器学习模型最常用的方法之一,下面关于梯度下降方法错误的是

A

梯度下降法可分为批量梯度下降法、小批量梯度下降法、随机梯度下降法

B

梯度下降法用来求解最小值,梯度提升法用来求解最大值

C

梯度下降法有很多优化方法,常用的有Adagrad、RMSprop、Adam

D

小批量梯度下降法、随机梯度下降法求解可能是局部最优,但批量梯度下降法一定是全局最优解

批量梯度下降法

- BGD 使用全部训练数据计算梯度: 每次迭代时,计算损失函数对参数的梯度需要用到整个训练集的所有样本。例如,如果有10,000个样本,每次更新参数时都会基于这10,000个样本的平均梯度。

- 优点:梯度方向稳定,收敛到全局最优解(对于凸函数)。

- 缺点:计算开销大,尤其是数据量很大时,每次迭代都需要遍历全部数据。

- 关键点: BGD 的“批量”是指全部训练数据,而不是“一个批次”(后者是小批量梯度下降的概念)。

小批量梯度下降(Mini-batch GD)的定义

- Mini-batch GD 使用一个批次的子集数据计算梯度: 每次迭代随机选取一小部分样本(如32、64、128个)计算梯度。例如,10,000个样本可能被分成多个批次(batch),每个批次包含64个样本。

- 优点:平衡了计算效率和梯度稳定性。

- 缺点:梯度方向有噪声,可能收敛到局部最优。

小批量梯度下降(Mini-batch GD) 可以看作是 批量梯度下降(BGD) 和 随机梯度下降(SGD) 的折中方法。

随机梯度下降(SGD):每次随机使用一个样本计算梯度。

Adagrad、RMSprop、Adam 都是梯度下降(Gradient Descent, GD)的优化算法,它们的主要目标是自适应调整学习率(Adaptive Learning Rate),以加速收敛并提高训练稳定性。在 PyTorch 中,Adagrad、RMSprop 和 Adam 都是官方提供的优化器(Optimizer),可以直接通过 torch.optim 模块调用。它们都属于自适应学习率优化算法,用于改进传统梯度下降法(如SGD)的训练效率和稳定性。

2

在逻辑回归模型中,你注意到模型的预测概率接近于0或1。这可能暗示了什么?

A

模型可能过拟合

B

模型可能欠拟合

C

模型的学习率可能设置得过大

D

模型的学习率可能设置得过小

在逻辑回归模型中,如果预测概率(预测值 y^y^)极端接近于 0 或 1,可能暗示以下问题:

关键原因分析

过拟合(A)

- 表现:模型对训练数据拟合过度,导致对噪声或异常点过于敏感,预测时过度自信(概率接近 0 或 1)。

- 验证方法:检查训练集和验证集的性能差异。若训练集准确率极高而验证集差,则可能是过拟合。

- 解决方案:

- 增加正则化(如 L1/L2 惩罚项,调整参数

C)。 - 获取更多数据或减少特征数量。

- 增加正则化(如 L1/L2 惩罚项,调整参数

特征问题

- 线性可分性:如果特征空间近乎线性可分,逻辑回归会通过极大似然估计将权重推向极端值(概率接近 0/1)。

- 特征尺度差异:未归一化的特征可能导致优化过程不稳定(但通常表现为收敛问题而非极端概率)。

学习率问题(C/D)

- 学习率过大(C):可能导致梯度下降跳过最优解,但通常表现为损失值震荡而非极端概率。

- 学习率过小(D):可能导致收敛缓慢,但与极端概率无直接关联。

选项排除

- B. 欠拟合:欠拟合表现为预测概率集中在 0.5 附近(模型无法区分类别),与题目描述的极端概率矛盾。

- C/D. 学习率问题:学习率主要影响优化过程,极端概率更可能是模型结构或数据问题导致。

正确答案:A(模型可能过拟合)

补充说明:

- 如果数据本身存在类别高度不平衡(如 99% 负样本),模型也可能倾向于预测多数类(概率接近 0 或 1),但这属于数据分布问题,而非模型问题。

- 极端概率还可能是正则化不足(如

C值过大)或特征工程问题(如存在完美区分性的特征)。

建议操作:

- 检查训练/验证集表现,确认是否过拟合。

- 添加正则化或交叉验证调整超参数。

- 检查特征空间是否线性可分(如通过可视化)。

3

线性判别分析(Linear Discriminant Analysis, LDA) 既是一种经典的监督分类方法,同时也是一种常用的监督降维技术。以下是关于LDA作为降维方法的详细说明:

1. LDA的核心目标

LDA的主要目标是找到一个投影方向(或一组投影轴),将数据从高维空间映射到低维空间,同时满足:

- 类间散度最大化:不同类别数据的投影尽可能分开。

- 类内散度最小化:同一类别数据的投影尽可能聚集。

通过优化这两个条件,LDA能在降维后保留判别信息,提升分类性能。

4 删除稀疏特征确实有可能帮助防止机器学习模型的过拟合,但其效果取决于具体场景和稀疏特征的性质。以下是关键点的分析和建议:

1. 稀疏特征为什么可能导致过拟合?

- 高维度低信息量:稀疏特征(如大部分值为0的one-hot编码或低频类别)可能引入噪声而非有效信息,模型可能记住这些无关模式。

- 样本不足:某些特征仅在极少数样本中出现,模型可能过度拟合这些异常个案(例如用户ID类特征)。

- 维度灾难:高维稀疏特征(如文本的TF-IDF向量)会增加模型复杂度,尤其当训练数据不足时。

5 在某些规划的分类器中,依据规划质量的某种度量对规划排序,保证每一个测试记录都是由覆盖它的‘最好的’规格来分类,这种方案称为()

A

基于规格的排序方案

B

基于度量的排序方案

C

基于规则的排序方案

D

基于类的排序方案

在规划分类器中,基于规则的排序方案是一种常用的策略,它根据预定义的规则对规划进行排序和分类。这种方案通过使用覆盖测试记录的”最好的”规则来进行分类判断,其中”最好的”通常是指根据某种质量度量标准来评估的规则。

分析为什么C是正确答案:

- “基于规则”强调了是通过规则来进行分类决策

- 题目中提到的”规格”实际上就是分类规则

- 这种方案确保每个测试记录都由最优质量的规则来覆盖和分类

- 规则的质量度量决定了规则的优先级

4 在使用GAN进行图像生成时,你发现生成的图像质量不高,存在模糊等问题。以下哪种方法可能有助于改善这个问题?

A

增加判别器的层数

B

使用Wasserstein GAN

C

增加生成器的层数

D

使用更大的输入图像尺寸

正确答案:B

你的答案:D

官方解析:

A. 增加判别器的层数: 增加判别器的层数可能会使判别器过于强大,导致生成器无法有效学习。

B. 使用Wasserstein GAN: 正确。Wasserstein GAN通过引入Wasserstein距离来改善GAN的训练稳定性,有助于改善生成图像的质量。

C. 增加生成器的层数: 增加生成器的层数可能会增加模型的复杂性,但不一定能改善生成图像的质量。

D. 使用更大的输入图像尺寸: 在GAN中,输入图像尺寸通常不影响生成图像的质量。

5 残差链接主要是改善深层网络退化问题,而不是梯度消失,因为梯度消失可以用BN等解决

Huber损失:结合了MSE和MAE的优点,当误差小于某个阈值时使用MSE,超过该阈值时使用MAE。这使得Huber损失在处理异常值时更加灵活。

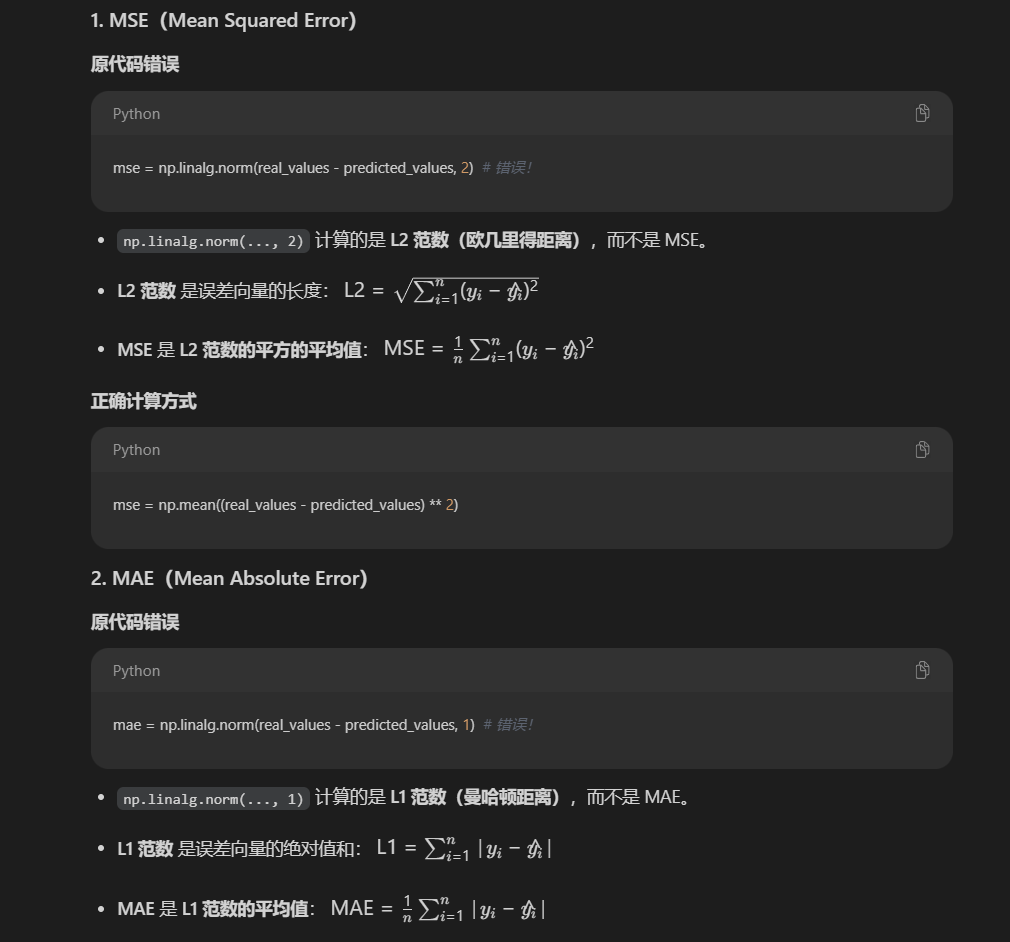

ML5 损失函数

cosine_similarity = np.dot(real_values, predicted_values) / (np.linalg.norm(real_values) * np.linalg.norm(predicted_values)) cosine_distance = 1 - cosine_similarity # 这才是余弦距离!

余弦距离等于1-余弦相似度,相似度越大,距离越小才对,损失越小

打印格式/输出格式

注意下面这种就是np.ndarray的打印格式

1 | [[1. 0. 0.] |