ML面试问题排查

说明L1 VS L2正则化 原理、区别和防止过拟合原理:

公式、过拟合原理(圆形和菱形约束,L1容易落在坐标轴)、求导和计算复杂性、

1.优化目标一般是损失函数加上正则化项,L1正则化表示正则化项为参数绝对值之和,乘以一个系数λ;L2表示… ,系数除以2是便于求导和消去次数

BN的核心思想和计算步骤、基本原理

在神经网络每一层输入前,对当前小批量特征数据进行标准化处理,将特征均值为0方差为1(不是缩放到0-1区间),避免内部协变量偏移,提高训练稳定性

计算步骤:计算均值和标准差,然后对该批次的特征进行标准化,即减去均值再除以标准差,该过程考虑防止除0通常会在方差求标准差开根号前加一个极小数,然后使用可学习的参数进行线性变化

原理:避免前一层数据输出过大或国小,防止前一层输出到下一层进行饱和区导致梯度消失

大模型常用RMSnorm和preNorm

降低计算量,省略了减去均值的操作,直接除以特征均方根,乘以λ

尽早稳定输入分布

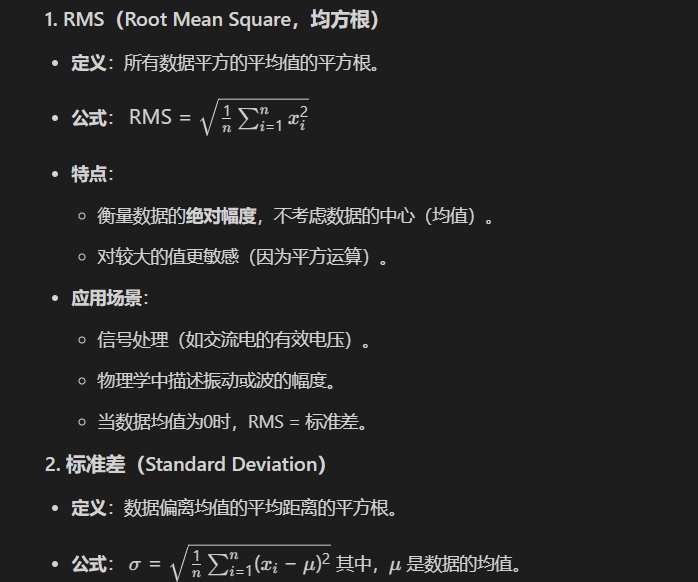

RMS vs 标准差

内部协变量偏移

神经网络训练中,前一层参数更新导致后一层输入数据的分布发生持续、剧烈变化的现象。这种分布变化会为后层训练带来干扰,最终降低模型训练效率、减缓收敛速度

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 Min的博客!

评论